Moteurs de recherche

Sommaire

Qu’est-ce qu’un moteur de recherche ?

Définition

Un peu d’histoire

Accéder à un moteur de recherche

L’hégémonie de Google

Pourquoi sont-ils essentiels ?

Internet et l’information

Une évolution permanente

Concurrence

Clientèle

Environnement législatif

Référencement, SEO, SEA et SXO

Comment fonctionnent ces moteurs de recherche ?

Le crawl

L’indexation

L’affichage des résultats

Bonnes et mauvaises pratiques

Google et autres moteurs

Un business modèle éprouvé

Des alternatives à Google de plus en plus crédibles

Les lois et des contraintes

Et demain ?

Qu’est-ce qu’un moteur de recherche ?

Définition

Définition : Un moteur de recherche est une application web permettant de trouver des ressources à partir d’une requête sous forme de mots. Les ressources peuvent être des pages web, des articles de forums Usenet, des images, des vidéos, des fichiers, etc. (source wikipedia)

D’outils pratiques aux prémices du web, les moteurs de recherche ont pris une place centrale sur le web aujourd’hui. Ils sont à la fois une boussole et une carte du web, ils orientent et suggèrent des recherches. Google, Bing, Qwant et les autres sont devenus un passage obligé pour qui cherche une information sur internet.

Un peu d’histoire

Historiquement internet était un moyen destiné aux scientifiques (et à aux militaires) de mettre à disposition de leurs pairs des documents. L’arrivée du grand public sur internet a fait se multiplier de façon exponentielle le nombre de sites et les difficultés à retrouver l’information désirée. Le premier moteur de recherche identifié, « Archie » est né en 1990 de ce besoin de retrouver des documents dans une toile qui commençait à s’étoffer. Ce pionnier a eu surtout le mérite d’exprimer clairement le besoin.

1994 vit naitre le premier annuaire, avec une logique différente, Yahoo. Si les moteurs de recherches tentent d’indexer tout ce qui peut exister, les annuaires sélectionnent et effectuent un travail de classement (alphabétique, thématique, etc…) pour faciliter la recherche. Yahoo devient très rapidement, le site le plus visité du web naissant.

Les années suivantes voient de nombreux moteurs historiques voir le jour, Lycos (1995), Excite (1995), Altavista (1996), Nomade (1996), etc…

En 1998, un OVNI, différent par son approche et le caractère épuré de son interface fait irruption : Google est né !

Le début des années 2000 voit à la fois la disparition des premiers moteurs historiques et l’ascension fulgurante de Google (élu meilleur moteur de recherche en 2000, rachat d’AOL en 2002). C’est dans ces années que se construit le modèle économique de la galaxie Google.

Accéder à un moteur de recherche

Si l’accès principal reste l’interface de recherche du navigateur (page de moteur, mais aussi barre d’adresse ou barre de recherche en plugin), ces dernières années ont vu se développer de nombreuses alternatives :

Les smartphones en premier lieu offrent de multiples possibilités d’interroger le web. Il n’est pas rare de voir des proches poser une question de vive voix à leur smartphone. Et si là encore Google reste dominateur, fortement aidé par les OS Android, ses concurrents tentent chaque jour de gagner des parts de marché.

Les assistants vocaux, comme Alexa, prennent chaque année un peu plus d’importance à modifient eux-aussi notre façon de chercher sur le web.

L’hégémonie de Google

Google a depuis des années préempté la recherche sur internet. S’il existe quelques ilots de résistance à cette domination insolente, le constat est sans appel. Seuls deux pays, pour des raisons géopolitiques essentiellement, ne sont pas dominés par Google, la Chine avec Baidu et la Russie avec Yandex. En France, la part de marché de Google est de 91% (PC de bureau : 80%, Mobiles : 97%)

Cette domination et les pratiques qui l’accompagnent (pratiques anticoncurrentielles, optimisation fiscale à outrance, etc…) sont cependant aujourd’hui de plus en plus vivement critiquées, voire sanctionnées. Que se soit en Europe ou même aux Etats-Unis, les mesures pour desserrer l’emprise de Google se font plus nombreuses et plus énergiques.

En parallèle, on voit grandir, lentement c’est vrai, des alternatives crédibles à Google. Parmi ces challengers, Qwant, le seul Français a encore beaucoup de mal à se faire une place économiquement viable.

| Moteur | Tous appareils | Desktop | Mobile |

| 90,86% | 80,24% | 97,01% | |

| Bing | 4,87% | 12,46% | 0,45% |

| Yahoo | 1,24% | 2,65% | 0,42% |

| Ecosia | 1,06% | 1,60% | 0,77% |

| Qwant | 0,97% | 1,82% | 0,49% |

| DuckDuckGo | 0,53% | 0,69% | 0,43% |

(Parts de marché des différents moteurs en France – source WebRankInfo – 2022)

Pourquoi les moteurs de recherches sont essentiels ?

Certains sites n’étant que la présentation du moteur de recherche, ils sont devenus eux même de fait « moteur de recherche ». C’est le cas de Google notamment.

Les annuaires, pour leur part, ont généralement évolués vers une offre plus généraliste mêlant informations, rubriques diverses et les fonctionnalités d’annuaires. Yahoo en est un parfait exemple.

Internet et l’information

A lire cette définition on devine aisément que, sans ce type d’application de recherche, internet serait quasiment illisible. Y trouver la bonne information relèverait du hasard le plus total.

Les moteurs de recherche sont devenus le coeur même de la toile.

Par cette position centrale ils sont devenus totalement indispensables. Il n’est plus possible aujourd’hui d’imaginer sa présence sur internet sans chercher à être reconnu par ces applications.

Aujourd’hui toute création de site internet correctement effectuée se complète d’une stratégie de référencement.

Une évolution permanente

Pour les moteurs de recherche donner des réponses fiables aux demandes des internautes est une question de survie. La domination insolente de Google n’est certainement pas acquise pour l’éternité et derrière cette hégémonie se cache une concurrence féroce. Trois grands axes forment aujourd’hui les moteurs de cette compétition :

-

La concurrence :

Le secteur de l’accès à l’information est en constante évolution et les pôles R&D de tous les acteurs du secteur sous pression continue. Poussé par des technologies en vogue (intelligence artificielle et machine learning, big data, etc…), les progrès sont constants. Les jeunes pousses technologiques par leur volonté de se faire une place au soleil de la silicon vallée forcent les géants du secteur à se renouveler. C’est un point d’autant plus sensible que la stratégie de rachat systématique de ces jeunes concurrents se heurtent de plus en plus souvent aux lois antitrust.

-

Une clientèle de plus en plus exigeante :

les internautes d’aujourd’hui ne sont pas ceux d’hier. A la fois plus à l’aise avec les nouvelles technologies et plus exigeants en terme de pertinence et d’efficacité, ils imposent de plus en plus leur vision aux entreprises du secteur. Les GAFA sont contraints par l’UX et les multiplication des usages. Chaque objet devient connecté multipliant les interfaces, la recherche sur le web se fait vocale, en langage naturel, avec un besoin grandissant de contexte.

-

Un environnement législatif qui se durcit :

sous la pression des opinions publiques mais aussi de finances parfois fragiles, les états renforcent régulièrement la législation vis à vis des GAFA et autres entreprises du secteur. Respect de la vie privée et gestion des données personnelles, lutte contre l’optimisation fiscale outrancière, respect de normes environnementales de plus en plus strictes, l’arsenal législatif (mondial et/ou local) devient chaque jour plus contraignant pour le secteur.

On le voit, le monde d’aujourd’hui n’est plus le long fleuve tranquille qu’il a été pour Google mais aussi Bing, Yahoo, Qwant et les autres.

Référencement, SEO, SEA et SXO

Au fil du temps, les préoccupations de référencement sont devenues un corolaire quasi obligatoire de la création de site internet.

La densité actuelle du web impose à qui veut s’y faire connaitre de prendre en compte les pratiques du SEO.

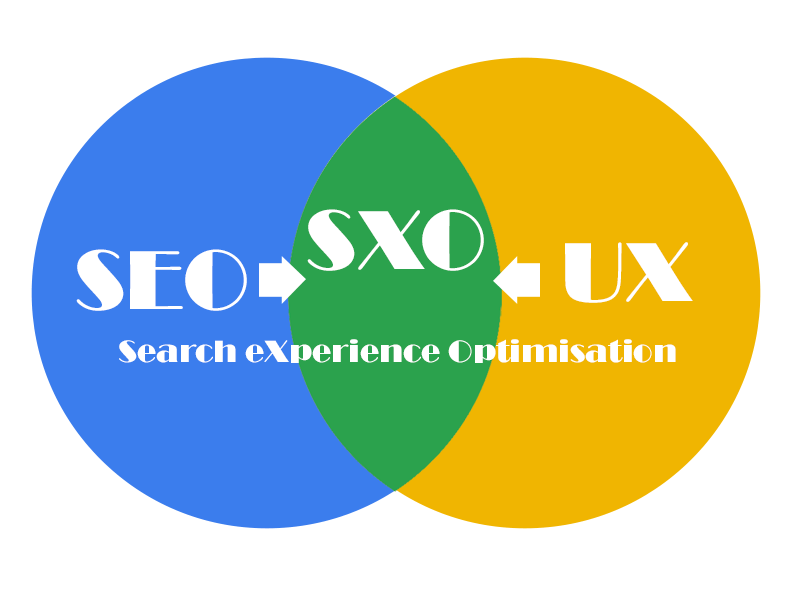

Les moteurs de recherche l’ont bien compris et imposent leur vision d’un site bien conçu pour le référencement naturel (SEO – Search Engine Optimisation) et proposent des places d’honneur à tous ceux qui optent pour le référencement payant (SEA – Search Engine Advertising).

Chacun y gagne

Pour les moteurs le bénéfice est double : en imposant leur besoins aux développeurs pour la création de site (hébergement de qualité, minimisation et déplacement des fichiers, fichiers sitemap et robots.txt, etc…), ils minimisent les couts d’exploration et de stockage des résultats, tout en améliorant la pertinence des résultats (structuration de l’info, hiérarchisation des titres, qualité du contenu, etc…) par une meilleure compréhension du contenu des sites visités.

La concurrence est féroce pour les premières places sur les pages de résultats et elle est tout bénéfice pour les moteurs de recherche.

L’expérience utilisateur ou UX : on parle d’expérience utilisateur pour qualifier le ressenti d’un internaute lors de sa navigation. On prend en compte des sujets aussi éloignés que l’ergonomie du site, la qualité de l’hébergement ou encore la réalisation technique du développement.

Cette concurrence est aussi intense lorsqu’il s’agit de SEA. Les entreprises se battent pour obtenir les meilleures places dans les systèmes d’enchères crées pour l’attribution des places « annonces » sur les pages de résultats.

Ne soyons pas trop négatifs tout de même, les autres grands gagnants de cette compétition sont les utilisateurs du web en général et des moteurs de recherche en particulier que nous sommes tous. En effet, si nous naviguons aujourd’hui sur des sites rapides à l’affichage (en particulier depuis des outils mobiles tels que les smartphones), ergonomiques et faciles à appréhender, c’est sans doute du en grande partie à ces différentes pressions. Le SXO (Search Experience Optimisation), mariage du référencement naturel et de l’expérience utilisateur (UX) et dernier avatar des lignes directrices du référencement en est le parfait exemple.

Comment fonctionnent ces moteurs de recherche ?

En indexant l’ensemble des contenus publiés sur le web. Chaque fois que vous publiez quelque chose sur internet, ces moteurs (en théorie) vous enregistrent dans leur index. Ils le restituent par la suite aux internautes en réponse à leur requêtes.

Pour qui publie sur le web, il est donc indispensable d’apparaitre comme faisant partie des meilleurs réponses possibles à une question posée (la meilleure, si possible). Il est dans un premier temps indispensable de bien comprendre comment fonctionnent ces moteurs de recherche pour, ensuite, les convaincre que vous proposez le meilleur contenu sur le sujet demandé.

La prise en compte du contenu d’un site internet se décompose en 3 grandes étapes.

Le crawl

Pour le faire, les moteurs de recherche disposent de petits programmes qui balayent en permanence la multitude d’informations existantes sur la toile, les « bots ». Les « bots » (ou « spider » ou « crawler ») sont les petits programmes automatiques (robots) chargés de cette tache en permanence, Googlebot pour Google, Bingbot pour bing, etc…

Pour ce faire, ils simulent une navigation humaine en suivant chaque lien proposé sur un site donné. Chaque page explorée est ainsi remontée pour être analysée plus en détail lors de la phase d’indexation. Chaque lien est enregistré (interne et/ou externe) et les liens brisés notés.

Google semble distinguer le crawl de découverte (discovery) du crawl d’actualisation (refresh) par des méthodes différentes. Sachez aussi que la fréquence de rafraichissement des informations liées à votre site dépend fortement du rythme auquel vous publiez de nouvelles informations. Sachez enfin que vous avez la possibilité d’indiquer aux différents moteurs de recherche que vous avez mis en ligne un nouveau contenu (site ou page) par le biais de leurs console de webmastering : Search console pour Google, Bing Webmaster Tools pour Bing par exemple.

Pour finir, il faut savoir que les robots définissent pour chaque site un « budget crawl ». Celui-ci définit le nombre de pages et la profondeur de navigation que les robots s’autorisent à traiter à chaque passage. Cette limitation ne concerne pas les petits sites. Les grands sites de plusieurs centaines, voire millier de pages seront sans doute traités en plusieurs passes.

L’indexation

C’est la phase suivante, dire qu’une page est indexée signifie qu’elle a été découverte par Google, que celui-ci la jugée pertinente et l’a enregistré et copié dans ses serveurs d’indexation (comme plus de 130000 milliards d’url !).

Dans les faits, cette indexation ne va pas de soi et il ne suffit pas de publier une page sur le web pour celle-ci soit automatiquement indexée. Pour qu’elle soir correctement « indexée », votre page doit remplir plusieurs conditions indispensables :

- La page doit être bien sur accessible : pas d’erreur serveur ou de page non trouvée

- Qu’elle soit indexable (c’est la moindre des choses 🙂 ). Le bot doit recevoir un code http satisfaisant en réponse à sa requête (200 en général) et ne pas trouver de balise noindex (dans la page ou sur un fichier robots.txt).

- Qu’il s’agisse d’un contenu unique ou d’une URL canonique. Google et autres ont horreur du contenu dupliqué.

Si vous désirez vérifier si les pages de votre site sont correctement indexées, essayez depuis google la recherche site:votresite.com. Toutes les pages qui s’afficheront sont indexées… pas les autres.

L’affichage des résultats

Cette dernière étape est la seule qui soit visible immédiatement des internautes. L’affichage dans les pages de résultats, les SERP (Search Engine Results Page), est aussi la finalité du travail de référencement.

Qu’il s’agisse de référencement naturel (SEO) ou payant (SEA), être bien placé sur ces pages est vital si on veut générer du trafic sur son site. Il faut, en effet, non seulement être sur la première page de résultat pour avoir des visiteurs mais de plus être dans les premiers de la page (les trois premiers de la page 1 attirent à eux plus de 55% du trafic).

Comme les deux premières étapes, l’affichage des SERP évolue fréquemment au gré des améliorations techniques, des évolutions d’algorithme ou des tendances du moment. C’est valable pour Google mais aussi pour l’ensemble des autres moteurs de recherche.

De plus, cet affichage, non content d’évoluer fréquemment, est multiple. Selon les requêtes (courte ou longue, locale ou généraliste, etc…) et les informations poussées par les sites remontés, l’affichage de la page peut varier de façon importante : modification des titres, affichage des descriptions sur 2 ou plusieurs lignes, affichage de date, d’avis clients, etc… Dans certains cas, les informations peuvent être mises en valeur dans un encadré en haut de page (featured snippet) ou encore multiples avec plusieurs liens pour le même site (sitelinks).

Pour creuser plus encore le sujet, prenez le temps de lire cet excellent article de WebRankInfo sur l’ensemble des fonctionnalités d’affichage des SERP.

Cette page est essentielle pour Google car, elle est aussi le support de nombreux encarts publicitaires générés par l’entreprise (les autres font de même mais sans doute avec un modèle moins abouti)

Bonnes et mauvaises pratiques

Les bonnes pratiques, le WhiteHat SEO

Séduire les moteurs de recherche pour un bon référencement naturel se fait sur le moyen et long terme. Il nécessite aussi une bonne préparation, un peu de rigueur, du bon sens et la connaissance de quelques règles de base à appliquer.

-

De la méthode

Soyez méthodiques, établissez vos objectifs, choisissez soigneusement les requêtes que vous ciblez et les pages auxquelles vous les associez. Vous vous positionnez sur un sujet fortement concurrentiel ? Pensez « longues traines » plutôt que d’affronter frontalement des « cadors » déjà bien installés.

-

Un contenu de qualité

Une fois ce travail effectué pensez à votre contenu. Travaillez la structure de vos informations, le rubricage du site, votre plan de navigation. Page par page, soignez votre rédaction, vos textes en fonction de la requête ciblée, vos visuels, la hiérarchisation de vos titres, créez des contenus uniques. Gardez toujours à l’esprit que votre page doit séduire vos visiteurs et être facilement compréhensible par un robot d’indexation. Ne négligez pas les interactions avec vos visiteurs, faites apparaitre les avis clients s’ils existent, offrez la possibilité de partager vos articles, pensez à créer une FAQ.

Les bonnes pratiques vous assurent une sécurité dans le temps : des résultats et pas de sanction.

-

Pensez technique

Soignez les aspects techniques de votre site. Pensez à avoir un bon hébergement, c’est un investissement indispensable. Amaigrissez vos fichiers autant que possible (éliminez le code inutile, minifiez les fichiers). Retardez le chargement des fichiers non indispensables, optimisez au maximum vos visuels (taille et poids).

Pensez à mettre en place un fichier sitemap.xml, un fichier robots.txt, configurez-les correctement. Implémentez des balises de données structurées en fonction du type de page. -

Soyez visibles

Faites vous connaitre, définissez une stratégie de netlinking. Créez une page GoogleMyBusiness, préparez là soigneusement.

Enregistrez-vous sur la SearchConsole de Google et les BingWebmasterTools pour assurer votre indexation et connaitre les éventuels problèmes sur vos pages.

Utilisez un outil de suivi statistique pour connaitre le résultats de vos travaux.

Si ces pratiques peuvent parfois sembler contraignantes, soyez surs qu’elles sont pérennes. Avec un peu de patience vous obtiendrez des très bons résultats sans crainte d’être sanctionné par Google et autres. Remonter la pente après une sanction de ce type peut parfois être très long.

BlackHat, GreyHat que sont-ils ?

Lorsque des règles sont établies, il existe toujours, pour de bonnes ou de mauvaises raisons, des moyens de les contourner, voire de les enfreindre. Les pratiques SEO n’échappent pas à la règle. Il existera toujours des concepteurs, des référenceurs qui tenteront de tromper la vigilance des algorithmes d’indexation pour forcer leur positionnement. On parle des ce cas de backhat ou de greyhat (qui se situe quelque par entre le blanc et le noir 🙂 ).

Il existe d’innombrables pages qui décrivent plus ou moins bien des pratiques telles que le cloacking de contenus, le spamdexing ou encore la génération automatisée de backlinks. Je vous laisse vous faire une idée par vous même.

Mon propos n’est pas de porter un jugement sur ces pratiques, elles existent, ceux qui les pratiquent savent ce qu’ils font.

Gardez cependant toujours en tête que vous écrivez avant tout pour vos lecteurs, ne vous aventurez pas à proposer du contenu incompréhensible ou illisible pour tromper un moteur de recherche, vos lecteurs finiraient par vous fuir.

Google et autres moteurs

Un business modèle éprouvé

Ce n’est un secret pour personne, Google ne vit que par et pour la publicité. Il en est de même, à moindre échelle sans doute, pour tous les autres moteurs de recherche. Les fonctionnalités de recherche, par essence gratuites, ne sont aujourd’hui qu’un produit d’appel pour attirer un public. Google est l’exemple extrême des dérives du net où les données personnelles des internautes sont devenues une manne que tous se disputent.

Il est incontestable que ce modèle fonctionne et génère des profits énormes. Alphabet (le groupe construit autour de Google), est devenu un « monstre » tentaculaire dont il est difficile d’appréhender la globalité. La publicité est devenu le point de convergence de cette galaxie, optimisé par les profils utilisateurs issus des data collectés.

Chaque clic sur le moteur de recherche ou les applications annexes vient enrichir les informations sur l’internaute et servir les besoins publicitaires.

Tous clients !

Il existe tant d’informations sur internet que les moteurs font un tri et n’enregistrent correctement que les contenus qui leurs semblent pertinents et intéressants pour leurs utilisateurs.

Ce dernier point est essentiel pour bien comprendre comment fonctionnent Google et consorts. Ne perdez jamais de vue qu’il s’agit d’entreprises qui vivent principalement de la publicité qu’elles insèrent dans leurs pages. Pour elles nous sommes à la fois clients (des résultats de recherche) et cibles publicitaires (pour la publicité embarquée et ciblée)

Aujourd’hui, c’est la réputation de fiabilité de Google qui y fait revenir les internautes et en fait un support publicitaire extraordinaire. Chaque personne qui se connecte sur un moteur de recherche ne reviendra que s’il trouve réponse à sa problématique !

Ainsi, leurs algorithmes d’indexation cherchent en permanence les meilleures réponses possibles aux requêtes qui leur sont soumises.

Une grande partie du travail en SEO porte sur l’optimisation de contenus pour faciliter la tache de ces petits robots. Il faut arriver à leur faire admettre que vous êtes la meilleure réponse possible dans votre domaine d’activité !

Des alternatives à Google de plus en plus crédibles

Il existe aujourd’hui de nombreuses alternatives à Google. Même si celui-ci conserve une position dominante quasi indécente, d’innombrables challengers tentent de grignoter ses parts de marché.

- Certains ne revendiquent aucune spécificité particulière : Bing, Yahoo

- D’autres se positionnent comme protégeant votre vie privée : Qwant (seule alternative 100% française), DuckDuckGo, StartPage

- D’autres encore proposent de reverser des fonds vers des causes particulières : Ecosia (causes environnementales), Lilo (projet de votre choix)

Les moteurs cités ne sont qu’une partie de cet univers de la recherche web, riche et constamment en mouvement.

Si Google par sa politique de rachat et son écosystème fermé tente d’étouffer cette concurrence, sa position dominante est de plus en plus remise en question.

Des lois et des contraintes

Ces dernières années, les sanctions pour différents manquements n’ont cessé de pleuvoir sur Google et son groupe.

Optimisation fiscale à outrance, respect des mesures liées à la vie privée (dont le RGPD), logiciels et applications imposées sur les appareils liés à Google et Android. Pour abus de position dominante avec Google shopping, l’Europe a durement sanctionné l’entreprise Google.

Aux Etats-Unis, la firme n’est pas mieux lotie. Le département de la justice et plusieurs états l’attaquent pour abus de position dominante et non respect de la loi anti-trust.

Ces diverses affaires pourraient bien affaiblir durablement l’entreprise.

Et demain ?

C’est une certitude, les moteurs de demain auront sans aucun doute beaucoup évolué. Il leur faudra suivre nos changements d’usage, la taille grandissante du web, trouver des solutions. La prochaine mouture de Google, MUM, sera le premier pas vers des capacités de recherche démesurées. MUM (Multitask Unified Model) sera

- Multilingue : recherche dans 75 langues quelle que soit la langue de formulation de la requête

- Multimodal : il effectuera les requêtes conjointement sur les textes et les images, puis à terme les vidéos et les enregistrements audio

- Multitâche : il sera en capacité de décomposer une requête en plusieurs taches distinctes et de les exécuter conjointement

Doté d’une IA ultra-performante, MUM sera capable de traiter des requêtes en langage naturel. Il traitera des doubles propositions, telles que « j’ai déjà fait ceci, comment faire cela ? ». Il pourra sans doute être force de proposition sur une demande comme « J’ai aimé Paris et Prague, mais pas Berlin. Quelle capitale va correspondre à mes goûts ? ».

De notre capacité et/ou envie d’accepter de nous voir retirer des pans entiers de notre libre arbitre et de notre capacité de choix dépendra aussi surement l’avenir de ces fonctions avancées.

Au delà, il est probable que des projets encore plus intrusifs voient le jour. La recherche prédictive (réponse à des questions non encore posées, un assistant se chargeant d’écouter et d’anticiper les questions) est à l’étude. L’émergence d’une indexation intégrée à la structure même du web qui rendrait le crawl obsolète et permettrait une indexation immédiate et totale aussi.

Quels choix feront nous ? Seul l’avenir le dira.